Beschleunigte KI- und ML-Workloads beziehen sich auf den Einsatz spezialisierter Hardware-Beschleuniger, wie GPUs (Graphics Processing Units) oder TPUs (Tensor Processing Units), um die Leistung von Aufgaben im Bereich der künstlichen Intelligenz (KI) und des maschinellen Lernens (ML) zu verbessern.

Herausforderungen und Voraussetzungen

Beschleunigte KI- und ML-Workloads erfordern häufig einen Hochgeschwindigkeitsspeicher, um die enormen Datenmengen, die verarbeitet werden, bewältigen zu können. Es besteht ein Bedarf an Speicherarchitekturen, die eine höhere Bandbreite liefern können, um die Rechenkapazitäten moderner Beschleuniger zu unterstützen. Dies könnte Innovationen im DRAM-Design beinhalten, wie breitere Speicherbusse, schnellere Speicherinterfaces oder die Integration von High-Bandwidth-Memory (HBM)-Technologien.

KI ist eine datenintensive Anwendung, die große Datenmengen erzeugt und verarbeitet. SMART Modulars NVDIMM, ein persistenter Speicher mit SafeStor™-Verschlüsselung, beschleunigt die Systemleistung erheblich beim Logging, Tiering, Caching und Schreibpuffern und ist damit eine ideale Speicherlösung für KI-Anwendungen. NVDIMMs sind eine ideale Lösung, um die Systemleistung bei KI- und ML-Anwendungen erheblich zu steigern.

SMARTs DRAM-Lösungen

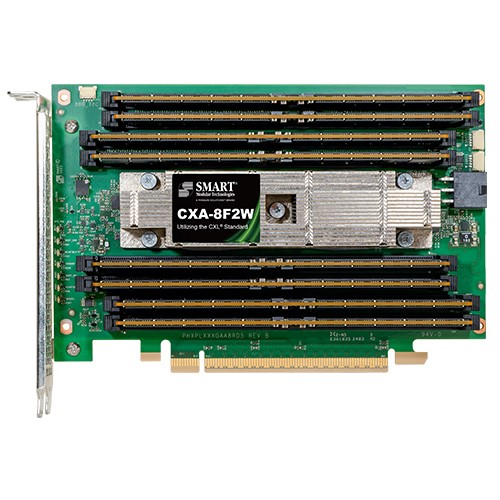

- CXL 8-DIMM AIC - SMARTs CXA-8F2W ist eine 8-DIMM AIC, die den CXL-Standard nutzt. Es handelt sich um eine Typ 3 PCIe Gen5 Add-In Card (AIC), die aus acht DDR5 RDIMMs besteht, die auf einem Full Height, Half Length PCIe Formfaktor-Modul montiert sind. Sie verwendet zwei x16 CXL-Controller, um zwei x8 CXL-Ports zu implementieren, die eine Gesamtbandbreite von 64 GB/s ermöglichen.

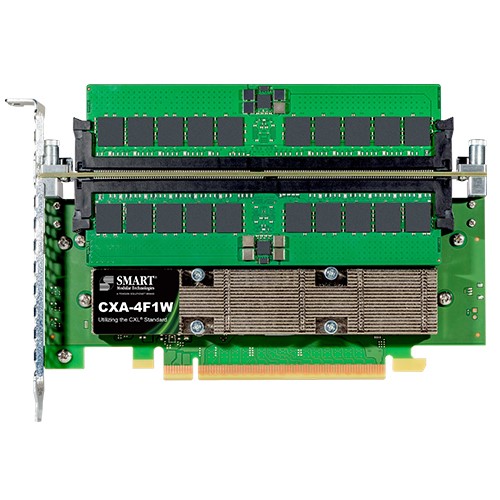

- CXL 4-DIMM AIC - SMARTs CXA-4F1W ist eine 4-DIMM AIC, eine Typ 3 PCIe Gen5 Add-In Card (AIC), die den CXL-Standard nutzt und aus vier DDR5 RDIMMs besteht, die auf einem Full Height, Half Length PCIe Formfaktor-Modul montiert sind. Sie verwendet einen x16 CXL-Controller, um einen einzelnen x16 CXL-Port zu implementieren, der eine Gesamtbandbreite von 64 GB/s ermöglicht.

- DDR5 Zefr ZDIMM - ZDIMMs (Zefr-Speichermodul) verwenden den proprietären Zefr™-Prüfprozess von SMART und garantieren so die branchenweit höchsten Betriebszeiten und Zuverlässigkeit. ZDIMMs werden streng getestet, um über 90% der Speicherzuverlässigkeitsfehler zu beseitigen, was eine maximale Anwendungsverfügbarkeit gewährleistet und die Zuverlässigkeit des Speichersubsystems optimiert.

SMARTs Flash-Lösungen

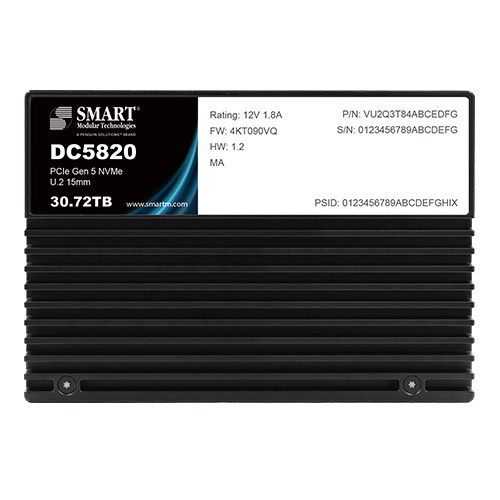

- DC5820 Data Center SSDs - Die DC5820 PCIe Gen5 NVMe Data Center SSDs von SMART wurden entwickelt, um den steigenden Anforderungen an Speichersysteme in Hyperscale-, hyperkonvergierten, Unternehmens- und Edge-Rechenzentren gerecht zu werden. Die DC5820 Data Center SSD-Familie bietet branchenführende KIOPs/Watt-Leistung mit überlegener Quality of Service (QoS) für gemischte Anwendungs-Workloads.